Nvidia ha annunciato il suo acceleratore H100 per data center e HPC. Questa GPU PCIe 5.0 è prodotta sul nodo 4N di TSMC e dispone di memoria HBM3 con larghezza di banda fino a 3 TB/s. L’Nvidia H100 succede all’attuale GPU A100.

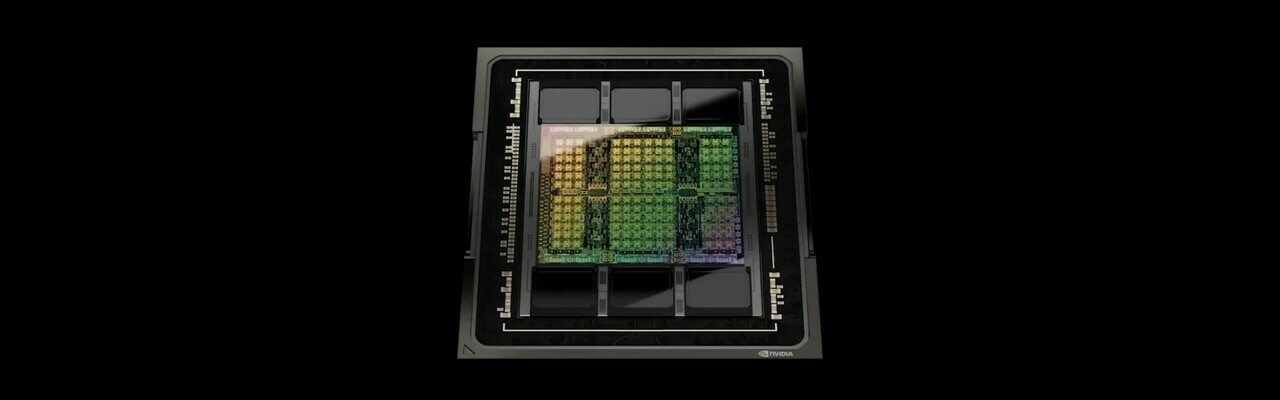

La GPU Nvidia H100 si basa su Hopper, un’architettura GPU rivolta a data center e HPC e Ampere seguito in questo settore. L’H100 è composto da 80 miliardi di transistor ed è prodotto con il processo 4N di TSMC. Questa è una versione modificata del processo N4 di TSMC, specifica per Nvidia. il Nvidia H100 è di nuovo un chip monolitico, proprio come l’A100. Inizialmente si vociferava che Nvidia avrebbe introdotto una GPU per data center con un design multi-chip, composta da diversi muore† AMD lo ha fatto l’anno scorso con la sua serie Instinct MI200.

L’attuale A100 è prodotto su una versione modificata del processo a 7 nm di TSMC ed è composto da 54,2 miliardi di transistor. Nvidia afferma che l’H100 offre una potenza di calcolo fino a tre volte superiore rispetto all’A100 a fp16, tf32 e fp64 e sei volte superiore a fp8. La GPU H100 misura 814 mm². È leggermente più piccolo dell’attuale GA100, che ha a Questo-area di 826 mm².

Nvidia H100 SXM5 (a sinistra) e H100 PCIe

HBM3 per il modello SXM5, HBM2e per la variante PCIe

Nvidia presenta due varianti dell’H100. L’attenzione sembra essere su una variante SXM5, che ne ha 128 stream multiprocessori per un totale di 16.896 core CUDA fp32. Questa scheda riceve 50 MB di cache L2 e 80 GB di memoria HBM3 su un bus di memoria a 5120 bit, per una larghezza di banda di memoria massima di circa 3 TB/s. Questa scheda riceve 50 MB di cache L2 e un tdp di 700 W. Gli utenti possono combinare diverse di queste GPU H100 SXM tramite l’interconnessione NVLink di Nvidia. Secondo Nvidia, la quarta generazione offre larghezze di banda fino a 900 GB/s.

Ci sarà anche una variante PCIe 5.0 x16 per server più standard. Questo modello riceve 114 SMS e 14.592 core CUDA. Inoltre, la variante PCIe riceve 40 MB di cache L2, proprio come l’attuale A100. Sorprendentemente, la variante PCIe ha ancora una memoria HBM2e più lenta, secondo il whitepaper di Hopper Nvidia pubblicato martedì† La quantità corrisponde al modello SXM da 80 GB. La variante PCIe ottiene 350 W tdp.

Nuove caratteristiche della tramoggia: motore trasformatore, set di istruzioni DPX

Ha anche adattato l’architettura Hopper stessa da Ampere. Hopper e H100 sono dotati di un nuovo motore trasformatore, che combina un nuovo tipo di nucleo Tensor con uno stack software per elaborare i formati fp8 e fp16 per l’addestramento della rete di trasformatori. Sono una sorta di modelli di deep learning.

Per il cloud computing, l’H100 può essere diviso in sette istanze† Ampère era già in grado di farlo, ma con Hopper sono completamente isolati l’uno dall’altro. Inoltre, Hopper riceve un nuovo set di istruzioni DPX per la programmazione dinamica. Nvidia afferma che l’H100 ha prestazioni fino a sette volte migliori di un A100 senza DPX in questo caso d’uso.

Sistemi DGX e SuperPod

Nvidia presenta anche un sistema DGX H100 con otto GPU H100. Con le sue otto GPU H100, un tale sistema ha 640 GB di memoria HBM3 con una larghezza di banda totale di 24 TB/s. Gli utenti possono combinare fino a 32 di questi sistemi DGX tramite connessioni NVLink. Nvidia lo chiama DGX SuperPod. Un tale sistema a 32 nodi dovrebbe offrire un exaflop di potenza di calcolo, afferma Nvidia. Questo si riferisce alla potenza di calcolo FP8. L’azienda sta costruendo un supercomputer EOS, composto da 18 SuperPod DGX con un totale di 4608 GPU H100.

Nvidia deve ancora annunciare i prezzi per la GPU H100. Inoltre, non è ancora noto quanto costeranno i sistemi H100 DGX o i SuperPod DGX H100. Inoltre, Hopper non dovrebbe essere utilizzato nelle GPU consumer. Entro la fine dell’anno, Nvidia presenterà la sua architettura Lovelace per le nuove schede grafiche GeForce RTX.

| Nvidia Hopper insieme alle precedenti GPU Nvidia HPC | |||

|---|---|---|---|

| Architettura | Tramoggia | Ampere | Volta |

| GPU | H100, TSMC 4 nm | GA100, TSMC 7nm | GV100, TSMC 12nm |

| Area della matrice | 814 mm² | 826 mm² | 815 mm² |

| transistor | 80 miliardi | 54 miliardi | 21,1 miliardi |

| Core CUDA (fp32) | SXM: 16.896 PCIe: 14.592 |

6912 | 5120 |

| nuclei tensoriali | SXM: 528 PCIe: 456 |

432 | 640 |

| Memoria | SXM: 80 GB HBM3 PCIe: 80 GB HBM2e |

40 GB / 80 GB HBM2e | 16GB / 32GB HBM2 |

| Vettore FP32 | SXM: 60 Tflops PCIe: 48 Tflop |

19,5 Tflop | 15,7 Tflop |

| Vettore FP64 | SXM: 30 Tflops PCIe: 24 Tflops |

9,7 Tflop | 7,8 Tflop |

| Tensore FP16 | SXM: 1000 Tflops PCIe: 800 Tflop |

312Tflop | 125 Tflop |

| Tensore TF32 | SXM: 500 Tflops PCIe: 400 Tflop |

156 Tflop | N / A |

| Tensore FP64 | SXM: 60 Tflops PCIe: 48 Tflop |

19,5 Tflop | N / A |

| Tensore INT8 | SXM: 2000 Cime PCIe: 1600 di altezza |

624 Cime | N / A |

| Tdp | Fino a 700 W | Fino a 400 W | Fino a 300 W |

| Fattore di forma | SXM5/PCIe 5.0 | SXM4/PCIe 4.0 | SXM2/PCie 3.0 |

“Ninja pancetta. Guru del caffè per tutta la vita. Drogato di cibo malvagio. Aspirante risolutore di problemi. Creatore tipico.”

You may also like

-

Intelligenza artificiale generativa e cybersecurity: quali rischi nel 2024

-

Elettrodomestici a portata di mano: controllare la tua casa con l’App del tuo smartphone

-

Battito cardiaco, come uno smartwatch può salvarti la vita

-

Honor 90: Il Nuovo Design Mozzafiato che Stupirà gli Appassionati di Smartphone

-

Sappiamo di più su come tenere il telefono acceso a letto con Pokémon Sleep